- Как происходит обучение нейронной сети

- Основные принципы обучения нейросетей

- Ключевые этапы тренировочного процесса

- 1. Прямое распространение (Forward Pass)

- 2. Расчет ошибки (Loss Calculation)

- 3. Обратное распространение ошибки (Backpropagation)

- 4. Обновление весов (Optimization)

- Роль природы в inspirровании алгоритмов

- Важность данных и вычислительной мощности

- Заключение

Как происходит обучение нейронной сети

Обучение нейронной сети — это сложный процесс настройки ее внутренних параметров, который позволяет ей выявлять скрытые закономерности в данных и делать точные прогнозы. Этот процесс, часто называемый тренировкой, является фундаментальным для машинного обучения и искусственного интеллекта, позволяя компьютерам решать задачи распознавания образов, классификации и принятия решений, имитируя работу человеческого мозга.

Основные принципы обучения нейросетей

В основе обучения любой нейронной сети лежит концепция адаптации. Изначально сеть состоит из множества искусственных нейронов, соединенных между собой синапсами с произвольно заданными весами. Эти веса определяют силу связи между нейронами. Процесс обучения заключается в последовательной корректировке этих весов на основе предоставленных данных, чтобы минимизировать разницу между фактическим выводом сети и ожидаемым результатом. Этот процесс требует большого набора размеченных данных и вычислительных ресурсов.

Ключевые этапы тренировочного процесса

Обучение можно разбить на несколько фундаментальных этапов, которые повторяются многократно.

1. Прямое распространение (Forward Pass)

На этом этапе входные данные подаются на входной слой сети и последовательно проходят через все скрытые слои. Каждый нейрон умножает входные сигналы на свои веса, суммирует их и пропускает через нелинейную активационную функцию, такую как ReLU или сигмоида. Результатом этого процесса является выходной сигнал сети — ее предсказание.

2. Расчет ошибки (Loss Calculation)

Полученное предсказание сравнивается с истинным значением (из тренировочного набора данных) с помощью функции потерь. Эта функция количественно измеряет, насколько вывод сети ошибочен. Часто используемые функции потерь включают среднеквадратичную ошибку для задач регрессии и перекрестную энтропию для задач классификации.

3. Обратное распространение ошибки (Backpropagation)

Это самый важный этап, на котором происходит непосредственно обучение. Алгоритм обратного распространения ошибки вычисляет градиент функции потерь по всем весам сети. Проще говоря, он определяет, какой вклад каждый вес внес в итоговую ошибку, и в какую сторону его нужно изменить, чтобы ошибку уменьшить. Этот расчет производится от выходного слоя назад к входному, используя правило цепочки из математического анализа.

4. Обновление весов (Optimization)

На последнем этапе вычисленные градиенты используются для обновления весов сети. Этот процесс выполняется оптимизатором, самым популярным из которых является алгоритм стохастического градиентного спуска (SGD) или его более современные variants, такие как Adam. Оптимизатор настраивает веса в направлении, противоположном градиенту, что ведет к постепенному уменьшению ошибки с каждой новой итерацией.

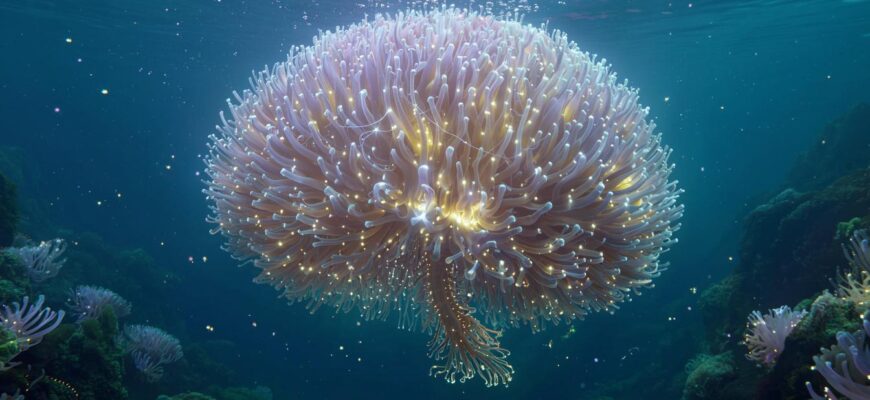

Роль природы в inspirровании алгоритмов

Интересно, что многие передовые алгоритмы машинного обучения черпают вдохновение в природе. Например, исследование коллективного поведения муравьев в рое показывает, как простые правила, выполняемые отдельными агентами, приводят к emergence сложного и интеллектуального поведения всей системы. Этот принцип «роевого интеллекта» используется в разработке децентрализованных систем оптимизации, которые могут применяться для настройки гиперпараметров нейронных сетей или управления многоагентными роботизированными системами. Подобно тому как муравьи координируют свои действия без централизованного управления, нейроны в сети совместно работают над решением общей задачи.

Важность данных и вычислительной мощности

Качество и количество данных напрямую влияют на результат обучения. Недостаточный или biased набор данных приведет к плохой обобщающей способности модели — явлению, известному как переобучение. Кроме того, современные глубокие нейронные сети требуют огромных вычислительных мощностей, часто предоставляемых графическими процессорами (GPU) и тензорными процессорами (TPU), чтобы выполнить триллионы операций, необходимых для обработки больших данных и обновления миллионов, а иногда и миллиардов параметров.

Заключение

Обучение нейронной сети — это итеративный и ресурсоемкий процесс, сочетающий в себе мощь математики, вычислительной техники и зачастую принципов, подсмотренных у природы. От прямого распространения сигнала до тонкой настройки весов через обратное распространение ошибки — каждый шаг критически важен для создания интеллектуальной системы, способной к обобщению и решению реальных задач. Понимание этих механизмов открывает двери к созданию более эффективных, точных и сложных моделей искусственного интеллекта, которые продолжают трансформировать наш мир, от разработки новых материалов до создания автономного транспорта.